先日、ここ(beingmelol.com)以外に持っているブログ3つを独自ドメイン化したぜイエー、という記事を書きましたが、

無事移行できたぜイエー!とか思ってたのですが、サブドメイン化した場合にはなんだかやらないといけないことがあるらしい。

嘘んんん。

ちなみにoriginal.com(仮称)というドメインを取って、

http://subdomain1.original.com/

http://subdomain2.original.com/

http://subdomain3.original.com/

というような感じにしたわけです。

*もくじ*

サブドメインを切ったらやるべき3つのこと

1.ディレクトリへアクセスできないように301リダイレクトをかける

サブドメイン切りっぱなしでほっとくと、

http://subdomain1.original.com/ ってしないとアクセスできないはずが、http://original.com/subdomain1/ってアドレスからもアクセスできてしまうらしい。

わーほんとだねー。(←試した)

このままほっとくと違うアドレス重複コンテンツが!!!ってことでグーグル様にコピーサイト認定されてしまってあまりよろしくないらしい。

ということで、

http://original.com/subdomain1/ は http://subdomain1.original.com/ と同じだからね!というリダイレクトをかけました。

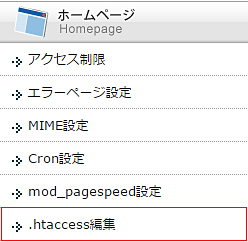

Xserverの管理画面、

.htaccess編集 → original.com の.htaccessに、

Redirect /subdomain1/ “http://subdomain1.original.com/”Redirect /subdomain2/ “http://subdomain2.original.com/”

Redirect /subdomain3/ “http://subdomain3.original.com/”

3行を付け足したら上手く行った…っぽい。多分。

2.ディレクトリへ検索ロボットがクロールできないようにする

1の処理で表向きは、

http://original.com/subdomain1/ と http://subdomain1.original.com/ は

同じことになったのですが、検索ロボットが回ってくる裏っかわ(?)は以前同じものが二つ存在することになっているらしい。なのでこのままだとやっぱり重複コンテンツ扱い。

なのでクローラにこっち(http://orijinal.com/subdomain1/)は見ちゃダメ!!!という処理をしました。

robots.txt をサーバ上の置くわけなんですが、どこに置いたらいいかが分からなかったので、

KB Robots.txt

というプラグインを使いました。

これは1ブログ毎にプラグインをインストールして作成しました。

User-agent: *Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /original1/

Allow: /

Googleのサーチコンソールで確認したら上手く行ってるぽかったです。多分。

3.WWWありとなしを統一する

このブログもそうなんですが、

http://www.beingmelol.com/

http://beingmelol.com/

このwww、あってもなくてもアクセス出来てしまいます。

そしてこれまた重複!!!って思われてしまうらしいです。しらんがな。

なのでこれも、「wwwついてないけどついてるのと一緒だから!」もしくは「ついてるけどついてないのと一緒だから!」という設定をしてやらないといけないらしいめんどくさい。

実はこのサイトもほったらかしだったんで、今回初めて設定してみました。

これまた.htaccess編集で、

RewriteEngine OnRewriteCond %{HTTP_HOST} ^www.(.*) [NC] RewriteRule ^ http://%1%{REQUEST_URI} [L,R=301]

って付け足したら上手くいったんです…このブログは!

サブドメイン切った方はまっっったくお手上げ。

っていうか、

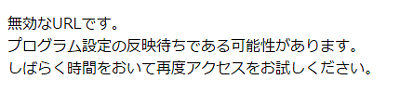

wwwありでアドレス打つと、

ってなるだけど、これって元から存在してないことになってるってこと?じゃあこのままでいいの?謎。

とりあえずわたしの限界なので謎は謎のまま…\( ‘ω’)/